为什么要使用 Amazon SageMaker 和 MLflow?

Amazon SageMaker 提供托管式 MLflow 功能,用于机器学习(ML)和生成式人工智能实验。借助此功能,数据科学家可以轻松地在 SageMaker 上使用 MLflow 进行模型训练、注册和部署。管理员可以在 AWS 上快速设置安全且可扩展的 MLflow 环境。数据科学家和 ML 开发人员可以高效地追踪 ML 实验,为业务问题找到适配的模型。

Amazon SageMaker AI 和 MLflow 3.0 的优势

随时随地追踪实验

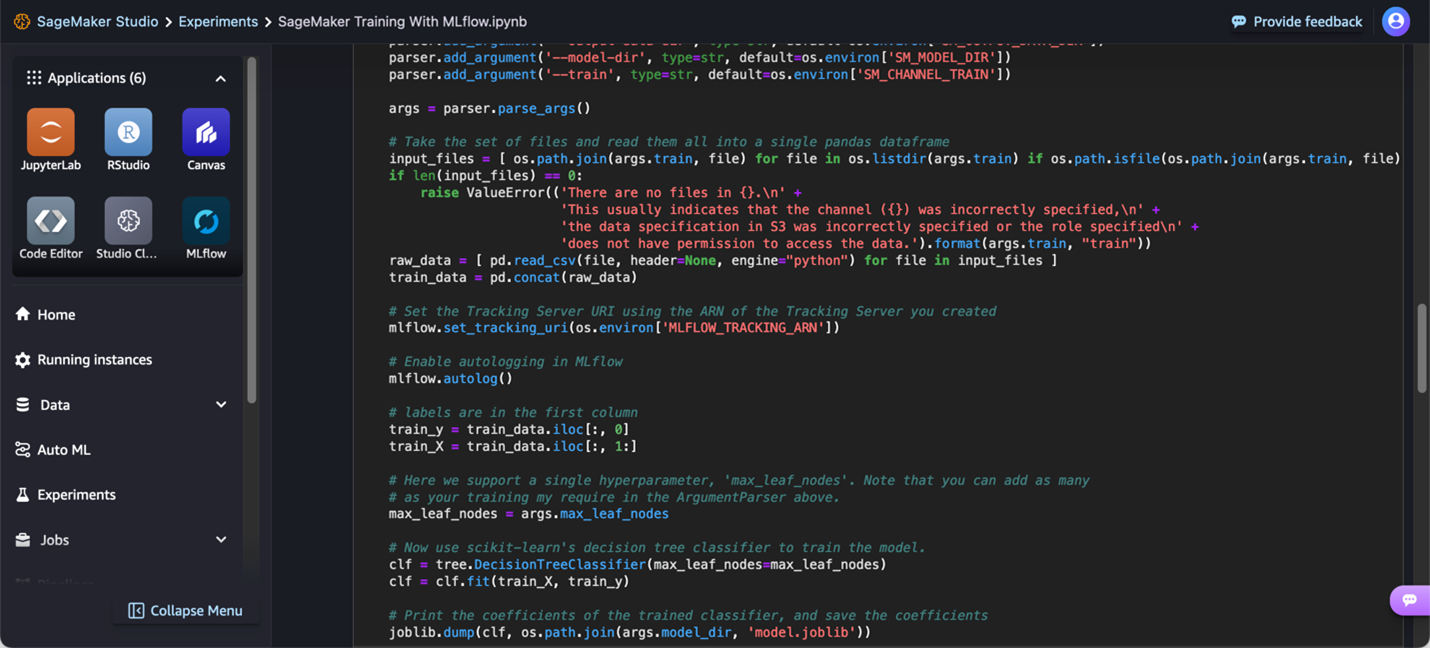

ML 实验在不同的环境中进行,包括本地笔记本电脑、IDE、基于云的训练代码或 Amazon SageMaker Studio 中的托管 IDE。使用 SageMaker AI 和 MLflow,您可以使用自己的首选环境来训练模型,在 MLflow 中追踪实验,以及直接启动或通过 SageMaker Studio 启动 MLflow UI 进行分析。

利用 MLflow 3.0 加速生成式人工智能的开发

构建基础模型是一个迭代过程,涉及数百次训练迭代,旨在找到最佳算法、架构和参数,从而实现最佳模型精度。完全托管的 MLflow 3.0 使您能够跟踪生成式人工智能实验、评估模型性能,并从实验阶段深入到生产阶段,更全面地了解模型和人工智能应用程序的行为。通过单一界面,您可以直观地查看训练作业的进度、在实验过程中与同事协作,并为每个模型和应用程序维护版本控制。MLflow 3.0 还提供高级跟踪功能,能够记录人工智能开发过程中每一步的输入、输出和元数据,使您能够迅速找出错误或异常行为的来源。

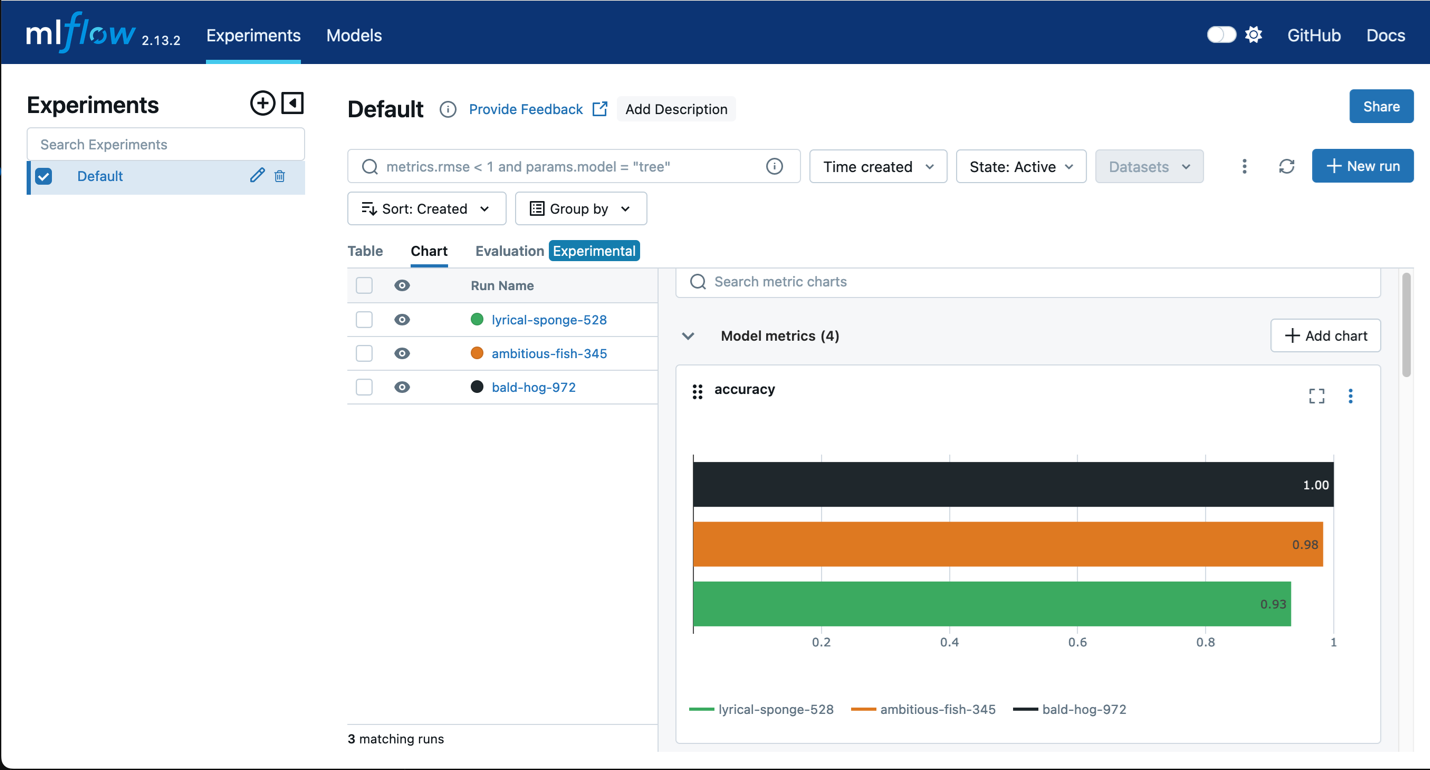

评估实验

需要分析和比较模型性能,才能从多次迭代中确定最佳模型。MLflow 提供散点图、条形图和直方图等可视化内容来比较训练迭代。此外,MLflow 允许评估模型,以确定偏差和公平性。

集中管理 MLflow 模型

多个团队经常使用 MLflow 来管理他们的实验,而只有部分模型会成为生产候选模型。组织需要一种简单的方法来追踪所有候选模型,从而作出关于哪些模型要继续前往生产流程的明智决策。MLflow 能与 SageMaker 模型注册表无缝集成,如此一来,组织便能看到他们在 MLflow 上注册的模型自动出现在 SageMaker 模型注册表中,并附有用于治理的 SageMaker 模型卡。这种集成能让数据科学家和 ML 工程师使用不同的工具来完成各自的任务:可将 MLflow 用于实验,将 SageMaker 模型注册表用于通过全面的模型沿袭来管理生产生命周期。

将 MLflow 模型部署到 SageMaker 端点

将模型从 MLflow 无缝部署到 SageMaker 端点,如此一来便不再需要为模型存储构建自定义容器。这种集成使客户能够利用 SageMaker 经过优化的推理容器,同时保留 MLflow 用于记录和注册模型的用户友好体验。